Gerald M EDELMAN

III. Biologie théorique et philosophie

Le passage initiatique par la mathématique pure procure des émotions esthétiques d'une telle intensité qu'il est impensable pour celui qui a été formé assez avant au sein de cette science de l'abandonner totalement. Au cours de mes études de mathématiques j'ai côtoyé algèbre et analyse, mais c'est initialement l'analyse, fondée sur la représentation la plus riche possible du continu, qui m'a procuré le plus de satisfaction. Pourtant c'est l'aspect discontinu du monde biologique qui frappe lorsqu'on pénètre dans le domaine de la biologie moléculaire. Et aujourd'hui l'analyse des génomes redonne un souffle exceptionnel à l'analyse logique des suites de symboles, comme nous le verrons plus loin.

Avec le mathématicien Philippe Courrège, j'ai d'abord tenté de représenter la régulation allostérique à partir des contraintes communes de la physique, en partant d'un formalisme continu. Cela nous a amenés à nous interroger, au cours d'un séminaire de travail régulier, sur les contraintes sélectives spécifiques de la biologie, et plus particulièrement de l'aspect théorique connu (et critiqué) aujourd'hui sous le nom de néodarwinisme. La richesse du postulat de la sélection (préexistence d'un domaine de variabilité et sélection, à la suite de l'interaction d'une région particulièrement stable avec l'environnement) allait de soi, et nous avons accepté avec un grand intérêt la proposition que me fit Jean-Pierre Changeux en 1971, de s'associer à notre groupe pour tenter de formaliser les caractéristiques originales du système nerveux central qui permettent la création de la mémoire et l'apprentissage. Ce séminaire est à l'origine de l'intérêt manifesté par l'un de ceux qu'on appelait les nouveaux philosophes, Jean-Marie Benoist, ce qui m'a conduit à m'exprimer sur le thème de l'identité au séminaire de Claude Lévi-Strauss au Collège de France.

Au moment où je terminais ma thèse, au laboratoire de Physique de la Matière Condensée à l'Ecole Polytechnique, et dans le service de Biochimie de l'Institut de Biologie Physico-Chimique, j'ai eu l'occasion de discuter avec Jacques Monod des implications philosophiques de ces travaux, et celui-ci m'a proposé de participer à la coordination du Centre Royaumont pour une Science de l'Homme qu'il venait de créer, en compagnie de Massimo Piattelli-Palmarini et Constantin Jelenski. Nous avons discuté nos premiers résultats sur la mémoire et l'apprentissage, puis développé toute une série de recherches sur la cognition avec Scott Atran, en particulier autour de la sémiologie de Thomas Sebeok et Umberto Eco (ce sera en partie à l'origine, plus tard, des rencontres bisannuelles de Fermo avec Ruggiero Romano, et du programme exploratoire d'anthropologie de l'occident par les non-occidentaux fondé sur une idée d'Anne Retel-Laurentin (1925-1983), Transcultura, qui devait me conduire un jour à m'installer en Chine).

A partir de 1990, j'ai recréé un séminaire ouvert aux questions théoriques et philosophiques, le jeudi en fin d'après midi, repris de 2001 à 2003 au Département de Mathématiques de l'Université de Hong Kong. Ce séminaire de travail informel, ouvert par l'Internet à des penseurs du monde entier en science et en philosophie, se poursuit sous le nom de Causeries du Jeudi. Et c'est finalement en 2007-2008 qu'à la suite d'une analyse approfondie, à la fois de la nature de la création de l'information, de la différence entre la reproduction et la réplication, et de l'organisation fine des génomes entre le codage des fonctions qui permettent la survie, et celles qui permettent la perpétuation de la vie que j'ai compris que ce que nous appelons Sélection Naturelle, est un authentique principe physique, celui qui permet de faire de la place pour accumuler l'information au fur et à mesure de sa création en utilisant une source d'énergie non pas pour détruire, mais pour éviter de détruire, ce qui est fonctionnel.Plus récemment j'ai compris que c'est le principe découvert en 1961 par Rolf Landauer qui est à la base d'une quantité de fonctions critiques pour la vie, incarnées sous la forme d'agents particuliers qui se comportent comme des démons de Maxwell.

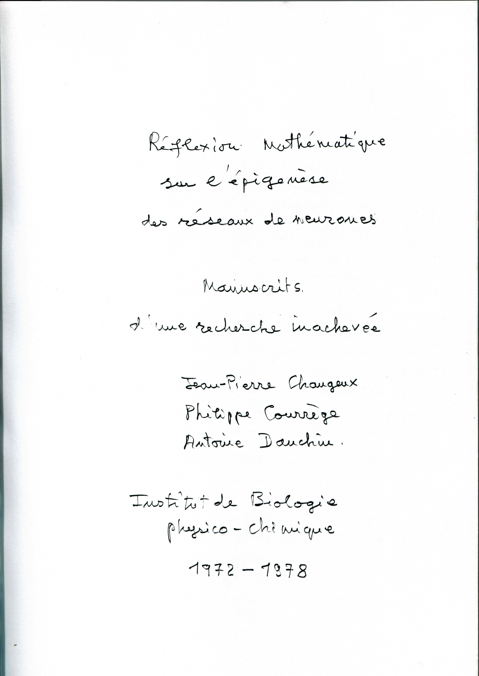

Pendant quatre ans Jean-Pierre Changeux, Philippe Courrège et moi-même nous sommes réunis —parfois en compagnie d'autres mathématiciens, Pierre Lusson, Bernard Saint-Loup, Gabriel Ruget, ou même Benoît Mandelbrot...— le mercredi après-midi à l'IBPC pour formaliser tel ou tel aspect des grands systèmes de neurones. De ces réunions sont issus un grand nombre de textes de travail traitant des propriétés des neurones isolés et des systèmes de neurones. Une très petite partie seulement en a été publiée. Cela tient sans doute à ce que l'association de trois personnalités très différentes permet difficilement d'aboutir à un texte qui, finalement, satisfasse les trois auteurs.

Pourtant nos travaux ont été, je crois, très constructifs et ont permis d'élaborer les grandes lignes d'une théorie générale de l'apprentissage qui me semble beaucoup apporter à notre compréhension des propriétés originales du système nerveux. Plus de trente ans après, au moment où, après une longue période de silence et de consolidation, les expériences sur le système nerveux central des vertébrés sont redevenues d'actualité, il serait certainement du plus grand intérêt de reconsidérer entièrement nos approches, et d'explorer plus avant la façon dont des rétroactions imprécises peuvent, par l'échec même de leur recherche de la précision, donner quelques unes des bases de ce qui pourrait être à l'origine des processus conscients, et de leur rôle dans la réorganisation cérébrale de l'environnement...

Plusieurs postulats sont à la base de notre théorie. Un postulat épistémologique d'abord : nous cherchons à rendre compte des propriétés des systèmes de neurones à l'aide d'une théorie sélective. Les postulats biologiques, fondés sur plusieurs familles de résultats expérimentaux et d'acquis passés (en particulier le postulat de Hebb, qui veut que l'activité des synapse soit modifiée par leur fonctionnement), restreignent notre étude de la mémoire et de l'apprentissage aux réseaux de neurones (en négligeant par conséquent la névroglie, et d'éventuels médiateurs gazeux comme NO) et plus spécialement aux connexions entre neurones, les synapses. Nous postulons qu'en dehors des propriétés désormais classiques des réseaux parcourus par des impulsions et que l'on retrouve dans les ordinateurs (avec les règles logiques que cela impose, ainsi que les boucles de rétroaction et de proaction) il existe une caractéristique originale des réseaux nerveux, à savoir la possibilité d'une évolution qualitative (et non pas seulement quantitative) des synapses en fonction de leur activité. En schématisant, nous imaginons qu'une synapse évolue dans le graphe d'états :

où elle passe au cours de la croissance d'un état virtuel (V) à un état instable, labile (L), puis, en fonction de son activité locale et de l'activité générale du neurone postérieur peut soit régresser et se déconnecter (R) soit se stabiliser sous une forme active (S).

Nous avons montré qu'avec ces postulats très généraux, un réseau de neurones était capable d'acquérir la capacité associative stable de reconnaître la forme des signaux afférents au bout d'un temps fini. Cette capacité de mémoire et d'apprentissage provient d'une transformation de la connectivité au cours du fonctionnement du réseau. Ainsi une forme temporelle est engrangée dans le réseau nerveux sous une forme géométrique. L'originalité principale de notre approche tient au fait que nous imaginons que l'apprentissage provient d'une perte de la connectivité. En outre on remarque que les contraintes génétiques nécessaires à l'établissement des règles de mise en place de cet apprentissage peuvent être très petites et, néanmoins, conduire à l'engrangement d'une quantité d'informations immense : chaque événement mémorisé correspond à un chemin parmi les 1015 synapses du réseau, ainsi le nombre de chemins possibles (donc des événements mémorisés) se trouve en pratique infini. La seule limite à notre possibilité d'apprendre – mais c'est une limite terriblement contraignante – est la lenteur de l'accès à notre cerveau par nos organes sensoriels.

En fait, en réalisant des simulations générales sur des réseaux modèles simples, nous nous sommes rapidement rendu compte que, dans toute sa généralité, notre modèle était trop puissant, donc trop vague. En construisant une fonction ad hoc pour exprimer l'évolution de chaque synapse dans le graphe d'états V->LRS il apparaissait possible de formaliser pratiquement n'importe quel type d'apprentissage. Or il est évident qu'une telle fonction d'évolution doit être fondée sur des contraintes biochimiques qui ne peuvent être quelconques. Afin de s'en faire une idée nous avons restreint notre analyse au cas, en principe très simple, de l'évolution épigénétique des contacts entre les motoneurones et une fibre musculaire. Depuis, il est apparu que l'adénylcyclase, thème un moment central de nos recherches, joue un rôle important dans le phénomène de mémorisation, par un mécanisme encore ignoré. J'ai fait l'hypothèse que ce qui comptait dans ce mécanisme n'était pas la molécule d'AMPc, mais la façon dont sa concentration varie au cours du temps, permettant de créer une figure temporelle spécifique, reconnue par des systèmes enzymatiques ad hoc. Cet aspect de la dynamique des processus biologiques (l'architecture est synchrone, et il faut prendre en compte la diachronie), mettra longtemps a être considéré sérieusement. Il est vrai qu'expérimentalement il s'agit d'une caractéristique particuliièrement difficile à maîtriser de façon reproductible.

Plus généralement, il était aussi utile de construire des hypothèses rationnelles sur les structures sous-jacentes à des processus cérébraux complexes comme le langage. En reliant ce qu'on sait des altérations générales de la performance individuelle à la suite de lésions cérébrales (travaux d'Alexandre Luria en URSS, en particulier), j'ai été amené à proposer quelques éléments de réponse à ces questions, en mettant en évidence les propriétés particulières de réseaux dédoublés. Le principe mis en jeu est celui d'un réseau construit pour conduire à une homéostasie motrice (c'est à dire à la correction automatique des écarts à une position optimale), mais incapable de la réaliser sans déclencher automatiquement un comportement moteur, qu'il faudra à son tour corriger, et ainsi de suite. On a là la base des deux caractères fondamentaux du langage, le substantif et le verbal, associés dans une mécanique qui stimule séquentiellement un balayage interne du cerveau.

Récemment, la conjecture que l'information est une authentique catégorie de la Nature, associée à la compréhension de la nature physique de la Sélection Naturelle, nous permet de reprendre entièrement cette exploration. Elle est désormais fondée sur l'idée de l'utilisation d'énergie dans un processus d'évitement de la dégradation des synapses, à partir d'une refondation, appliquée à la Biologie, du concept d'information.

Mais avant d'entrer dans le vif du sujet, je tiens à mettre en évidence à nouveau ce qui est original dans la cette pratique de la pensée humaine, que nous nommons Science.

Cela se réalise sous forme de prédictions expérimentales (observations ou expériences), qui, elles-mêmes, sont de deux types généraux. Ou bien les prédictions sont existentielles (on devra découvrir l'objet prédit) ou bien elles sont phénoménologiques et portent sur des relations qu'on peut affecter par l'expérience. Dans ce cas, elles sont susceptibles d'être vérifiées, et par conséquent réfutables (on devra réaliser un dispositif expérimental capable d'explorer ce qui a été prédit, et le confirmer ou l'infirmer). La réaction du réel à l'observation passive ou provoquée est ce qui permettra de valider le modèle, et d'en mesurer le degré d'adéquation.

![]()

Le processus ainsi décrit est génératif : tout défaut de prédiction remet en marche le processus de construction et de validation des modèles. Un modèle naît ainsi et dure tant qu'il n'est pas grossièrement invalidé. Certaines de ses prédictions ne sont pas vérifiées, et il faut alors mettre en cause ses relations avec le Réel, en faisant en sens inverse le chemin qui a conduit aux prédictions inexactes. Au cours de ce processus inverse, on remonte — difficilement — au travers d'étapes que je ne discute pas ici, aux postulats qui lui ont donné naissance, pour les modifier, les préciser, et le plus souvent en réduire le nombre. C'est à cette étape qu'interviennent de façon cruciale les éléments de la critique : tous les modèles du monde ne sont pas également possibles, il y a des règles de "bonne conduite" à respecter, la réduction du nombre des postulats et des hypothèses nécessaires en est une. Il doit aussi rester bien clair que la persistance d'un modèle ne justifie nullement son identification avec le Réel qu'il représente. De même, le risque est grand de croire, lorsqu'on rencontre un même modèle servant à représenter deux aspects différents du Réel, que cela signifie que ces deux aspects relèvent de la même explication sous-jacente. En fait ces coïncidences-là ne sont que la mesure de notre incapacité à être plus imaginatifs, nous en verrons plus bas un exemple.

Il faut retenir de cette brève description de notre façon de produire le savoir, que c'est notre propre impuissance à comprendre le monde qui nous fournit des moyens exploratoires d'une puissance insoupçonnée, parce que cela nous impose un dialogue formel entre deux niveaux pertinents, les modèles du monde, et sa réalité et que la structure même de ce dialogue est, au sens le plus profond, créatrice.

Lorsque les objets de la chimie deviennent "vivants", de nombreuses difficultés apparaissent : bien qu'intuitivement on puisse encore les définir (ou plus exactement les isoler) plus ou moins facilement, ils se présentent toujours avec un flou étranger au monde de la physique ou de la chimie. C'est qu'on retient des organismes vivants un caractère abstrait, qui exprime l'idée d'organisation, de structure, d'individualité, et surtout l'idée de fonction associée à l'idée d'évolution. Ce qui compte par conséquent, lorsqu'on définit la vie, est un ensemble de processus originaux, spécifiques et reconnaissables par leurs caractéristiques formelles. Le triplet Darwinien (né en réalité dès le temps d'Empédocle, repris dans la pensée courante — on en trouve une discussion dans les célèbres Diaries de Samuel Pepys — puis par Maupertuis, Malthus et Darwin) qui fait évoluer les systèmes matériels : Variation / Sélection / Amplification, crée des fonctions, qui capturent des structures pour se mettre en œuvre. Qu'est-ce donc que la vie ? A cette question Schrödinger proposait surtout de répondre par l'identification d'un processus permettant de relier l'hérédité et ses mécanismes abstraits à la physique d'un objet, qu'il imaginait sous la forme d'un "cristal apériodique", qui pourrait avoir une structure filamenteuse... On sait ce qu'il est advenu de cette remarquable intuition avec la découverte de la structure de la double hélice de l'ADN dix ans plus tard. Mais aujourd'hui il n'est pas possible de se contenter de cette seule structure pour rendre compte de la vie. Trois processus et deux lois centrales sont nécessaires pour définir un organisme vivant. Les deux premiers mettent en jeu de petites molécules (comportant quelques dizaines d'atomes), ce sont le métabolisme - auquel correspond l'interconversion de molécules en d'autres molécules, dans un flux permanent qui isole certaines espèces chimiques de l'environnement, les intègre, les modifie, et y rejette d'autres espèces, et la compartimentation —il n'y a pas d'organisme vivant sans un intérieur et un extérieur. Les objets de base qui permettent la genèse de ces processus sont de petites molécules, mais l'organisation correspondante possède une échelle qui a un certain caractère macroscopique : le dialogue entre échelles différentes est une caractéristique essentielle de la vie. Il s'y ajoute un rôle essentiel du temps. La vie ne se manifeste que dans un devenir.

Un processus plus abstrait, assurant le transfert de l'information, a été découvert plus récemment. Il forme le cœur de la biologie dite "moléculaire". Ce processus opère à une échelle intermédiaire, "mésoscopique" (mis à la mode par son échelle spatiale, celle du nanomètre, nanoscopique donc), celle des macromolécules, constituées de milliers, de millions, voire de milliards d'atomes. Ce processus, divisé en deux processus successifs, régle les flux de l'information (concept que je reprendrai plus bas de façon plus précise, mais dont le flou du sens commun donne ici une idée suffisante) nécessaires à la vie. L'autonomie d'un être vivant, sa reproduction, son développement et sa survie supposent l'existence d'une mémoire, le génome, qui transmet de génération en génération l'information permettant le développement de l'organisme. L'information portée par l'ADN dirige la synthèse des protéines, via la synthèse d'un intermédiaire, un ARN messager. Elle dirige aussi la synthèse d'ARN ayant directement une fonction dans la cellule, et ne sont pas de simples intermédiaires. Elle est aussi dans l'ADN porteuse d'une dimension géométrique (la longueur même de segments d'ADN a un rôle dans son organisation) et temporelle (les processus en jeu se déroulent dans le temps, ce qui implique que certaines parties du génome puissent jouer le rôle de minuteurs). Les protéines sont douées de propriétés qu'on peut dire manipulatrices, parce qu'elles permettent les interconversions du métabolisme et les constructions nécessaires à la compartimentation.

Ajoutée à la première loi centrale, la loi de complémentarité, règle de réécriture qui permet à l'ADN de se recopier en deux molécules voisines sinon identiques, transmettant ainsi la mémoire héréditaire, la correspondance entre des segments du texte de l'ADN et chaque type de protéine est au cœur de la définition de la vie. La correspondance physique entre l'ADN et les protéines, peut se représenter de façon abstraite par une suite de "règles de réécriture". Les règles de réécriture du génome de l'ADN à l'ADN (la réplication), et de l'ADN aux protéines, la transcription puis la traduction, au travers de la correspondance du code génétique, sont totalement incluses dans la suite des nucléotides et des acides aminés qui leur correspondent. La correspondance entre l'ADN et les protéines introduit à la fois le temps et l'espace dans une représentation de la vie cellulaire (ou de l'organisme, s'il est multicellulaire) qui fait référence à elle-même. C'est cette correspondance qui permet de parler de programme, lorsqu'on considère l'action de l'ADN, perçu comme l'objet formel qui constitue les chromosomes. La réalisation effective d'un individu correspond aux conséquences de l'expression de son programme génétique, sous la forme de ces objets manipulateurs que sont les protéines (qui sont aptes, en particulier, à manipuler la substance même du programme, en le recopiant, et en y introduisant des variations, selon des règles bien prescrites). Il est possible, dès ce stade de la formalisation du vivant, de souligner l'importance conceptuelle de la séparation physique, concrète, effective, entre le programme et son support matériel, et les objets qui résultent de son expression.

Les organismes vivants produisent des traces qui ont une série de propriétés originales qui les rendent immédiatement reconnaissables : l'Homme et sa technique peuvent en donner de nombreux exemples, et, par l'image de la barque de Delphes, les Grecs faisaient déjà remarquer que la persistance de la forme joue un rôle important dans ces objets. C'est donc en considérant la nature de ce qui forme la permanence de la vie que nous devrons constater que nous nous trouvons en face d'un ensemble de propriétés de nature très abstraite, et que nous devrions plutôt prendre en compte les relations entre objets que les objets eux-mêmes dès qu'il s'agit du vivant. Il faut bien se garder cependant de l'attitude idéaliste qui conduirait à penser que les relations peuvent exister en elles-mêmes, dans un monde dépourvu d'objets. Illustrons cela. Plutôt que rester à notre échelle et ne considérer que les animaux ou les plantes, comme beaucoup en ont la tentation première, ce qui doit être considéré d'abord est donc l'atome de vie, la cellule, et les mécanismes de son hérédité. Une mémoire héréditaire s'y transmet de génération en génération, véhiculant ce que le sens commun appelle une information, au travers d'un processus que les modèles actuels de l'hérédité considèrent comme la mise en œuvre d'un programme, dans un sens voisin de celui qui a été consacré par l'usage de ce mot en informatique. En particulier la réflexion sur l'idée de programme nécessite de prendre en compte le fait qu'il s'agit d'une séquence — non seulement synchronique mais temporelle — de prescriptions, donc d'opérations qui ne sont pas seulement formelles mais doivent, à un moment ou l'autre s'incarner dans la manipulation concrète d'une machine. Mais parler de programme rend d'abord souhaitable de revenir sur ce que signifie l'information, et sur le contenu formel d'un programme, pour voir si les métaphores usuelles correspondantes sont appropriées, et si leurs conséquences formelles connues sont applicables au vivant.

Show all § | Hide all §

La première formalisation mathématique de l'information, ou plus exactement de la communication, a été proposée par Shannon. Elle a servi initialement à étudier la transmission de messages séquentiels le long de lignes télégraphiques, ou par tout autre moyen de transmission électromagnétique, affecté par des perturbations aléatoires produisant un certain niveau de "bruit", en évitant soigneusement de prendre en compte le sens des messages transmis. La théorie correspondante dérive d'un sous-ensemble de la théorie générale des ensembles mesurables. Elle ne cherche pas à prendre en compte autre chose que le contenu local du message, en évaluant sa probabilité locale, et d'ailleurs Shannon affirme explicitement ne pas se soucier du problème de la signification des messages.

Dans cette formalisation, ce qui est pris en compte est la probabilité d'un message, qui, dans la description la plus fréquente des génomes, se réduit à une lettre à une position donnée du texte du programme génétique. Un enrichissement évident serait de considérer non plus les lettres du programme mais les mots (suites de lettres) pertinents. Mais encore faudrait-il les connaître ! L'information véhiculée par la mémoire héréditaire contient donc un autre mode de connaissance que la simple suite des lettres du programme formant la séquence de l'ADN. Plus exactement, il conviendrait de distinguer l'information, selon la machinerie de réplication — qui peut être représentée par l'information de Shannon — et l'information de l'expression génétique, qui demanderait un tout autre formalisme.

Bien qu'elle corresponde à une certaine idée que nous en avons, cette première définition de l'information est très primitive et tout à fait incapable de décrire la plupart des propriétés de ce que le sens commun appellerait "information". Par exemple, une vue plus élaborée montrerait que considérer un événement isolément est souvent dépourvu de signification, que le contexte du message, ou son histoire, peut en altérer le sens : c'est là ce que montre l'image courante, mais incroyablement ignorante et simpliste, du singe tapant au hasard sur une machine à écrire et créant, sans le savoir, le texte d'une pièce de Shakespeare. De même, lorsqu'on considère la vie, et plus précisément l'information contenue dans la suite des lettres de l'ADN (sa "séquence"), l'approche en question ne prend pas le contexte ou la sémantique en compte, et se trouve par conséquent incapable d'exprimer les propriétés originales de la vie. Ce niveau très primitif peut cependant apprendre un peu sur la richesse en information du message génétique, par exemple en nous aidant à découvrir les anomalies du texte génomique et en particulier les lieux où se trouvent les gènes dans un texte souvent sans signification facilement apparente. Enfin, c'est ce niveau d'information que voit la machinerie de réplication au cours de la duplication de la double hélice de l'ADN : c'est là en effet qu'intervient la fidélité de la réécriture, sans référence explicite à la signification du message génétique, problème qui se trouve au cœur de l'analyse de Shannon.

Lune des raisons sociologiques du succès de la loi de Shannon est que sa forme mathématique est semblable à celle d'une autre loi, découverte dans le domaine de la thermophysique, et sujette à de nombreuses élucubrations philosophiques, le plus souvent d'autant plus populaires qu'elles sont plus fumeuses. Cette coïncidence a eu des conséquences conceptuelles fâcheuses, lorsqu'il s'est agi de relier l'information à la vie. Il est tout à fait courant, particulièrement dans les discours non scientifiques, mais qui veulent utiliser la Science en guise d'argument d'autorité, de rencontrer des raisonnements où l'on prétend démontrer l'identité de l'information véhiculée par un processus, et des variations de l'entropie mise en jeu, alors que cette dernière est une propriété de la matière initialement définie par les modalités de l'échange de chaleur entre objets macroscopiques. Il est facile de comprendre combien cela relève de l'idéologie qui affirme que le monde se dégrade sans cesse et va vers un désordre croissant, inévitable, mais contre lequel lutterait la vie. Déjà Schrödinger dans son livre, imaginait que les organismes vivants sont des "consommateurs d'entropie négative" et qu'ils restituent un monde plus organisé. Par sa grande honnêteté, et sa clairvoyance, il avouait pourtant que ses confrères physiciens mettaient en doute le fait que le métabolisme puisse consommer de l'entropie négative en dégradant les molécules, plutôt que l'énergie, et il était bien conscient que ce ne sont pas les phénomènes statistiques qui sont les plus importants en biologie.

Il y a bien sûr un lien entre ce que nous percevons comme ordre et la façon dont les choses évoluent (ce qui est en partie l'objet d'étude de la thermodynamique), mais l'ordre est une fonction non seulement de la réalité considérée en elle-même mais aussi de l'observateur. De même l'information qualifie non seulement l'état d'un système donné, mais requiert aussi une certaine connaissance du système et de l'observateur. Comme l'ordre, l'information est un concept relatif, et doit prendre en compte les différents systèmes en interaction.

En physique, du moins dans les situations les plus simples, l'information peut être assez facilement reliée à la thermodynamique. Mais cela suppose ne considérer que les objets, très nombreux et très simples par conséquent, à la lumière très restrictive de leur comportement global statistique. Les relations entre objets, telles que celles dont nous avons vu l'importance fondamentale en biologie, ne sont pas prises en compte dans de telles descriptions. On en reste au domaine du quantitatif et du local, plus que du qualitatif et du global, comme il le faudrait pourtant. La compartimentation, par exemple, se réalise par la fermeture d'un feuillet constitué d'une double couche de molécules : le simple fait de fermer - événement local mineur - conduit à un objet global irréductible à l'original, puisqu'il permet de définir un intérieur et un extérieur.

Or, les relations dont il est question ont la particularité d'être organisées selon un patron spécifique qui, au moins pour certaines d'entre elles, s'exprime à la manière dont s'exprime un algorithme, placé dans une machine appropriée. Ainsi la biologie nous propose une métaphore qui ouvre un champ nouveau, celui de la programmation et de l'informatique. Il ne s'agit pas pour autant d'abandonner l'hypothèse du rôle central de la forme, à laquelle se rattache l'étude macroscopique de la morphogenèse par exemple, mais de considérer qu'un programmeest un type original de forme, et de rechercher quel est le lien entre la forme du programme et la forme de l'organisme dans sa totalité. Le comprendre devient alors explicatif. Et cela peut se justifier, par l'expérience !, en montrant que la compréhension du programme permet une action prévisible sur le devenir effectif - concret - des formes en cause. Mais, avant d'aller plus loin, voyons d'où provient l'expression quantitative de l'information dans ses relations avec celle de l'entropie.

En termes d'information de Shannon, il est facile de définir l'information mutuelle entre des couples d'événements. On remarque alors que l'expression finale ressemble à la loi de l'information mutuelle selon Shannon : il suffit simplement de changer la forme de la fonction distance utilisée dans la loi du χ2, où elle est x2-1, en xlog2x. Ces deux fonctions se comportent de façon très semblable autour du point x0=1 (elles sont représentées par des courbes osculatrices) : leur valeur, leurs dérivées première et seconde sont égales. En fait, si l'on se propose de mesurer l'information mutuelle au moyen de lois plausibles, on est conduit à la conclusion que l'enveloppe de toutes ces lois n'est autre que la fonction information de Shannon. Par conséquent, la fonction xlog2x est la fonction naturelle qui devrait être utilisée comme mesure de l'interaction dans la plupart des cas. Mais cette affirmation est de portée plus générale. Elle signifie qu'il est naturel de trouver la même fonction mathématique dans de nombreuses situations sans autre parenté : lorsque l'on trouve que la modélisation d'un phénomène conduit à une fonction de la forme xlog2x il serait prudent de ne pas en conclure aussitôt que l'analogie s'étend à la nature des phénomènes décrits par cette même fonction.

Le concept d'information mutuelle est une approche où l'on tient compte d'une mesure, d'une distance entre des aspects comparables des processus analysés. Cela peut se réaliser localement, comme avec l'information de Shannon, mais ne peut-on aussi essayer de mettre en évidence des propriétés plus fines, ou plus générales ?

Une première façon de le voir est de considérer l'information contenue dans une chaîne de caractères, métaphore encore très réductrice mais éclairante du programme génétique, et d'étudier les diverses manières de la représenter de façon symbolique. Peut-on décrire de façon résumée une séquence ? Depuis plus de trente ans, Kolmogorov et Chaitin, suivant Solomonoff aux USA et l'école soviétique d'électronique, ont formulé le problème ainsi. Une manière de considérer la chaîne, est d'essayer au moyen d'une procédure codée, d'un algorithme, de réduire sa longueur, de la comprimer (afin, par exemple, de la faire tenir dans une partie aussi petite que possible de la mémoire d'un ordinateur), sans pour autant altérer ses performances (au moins en termes de précision, sinon en termes de temps), en bref, sans perdre son contenu en information.

Cette façon de procéder s'apparente au problème général de la calculabilité en nombres entiers. Turing, en 1936, a montré que raisonner sur les nombres entiers peut se faire à partir de règles universelles très simples, qui nous permettent de réaliser toutes sortes de calculs. Parce qu'une chaîne de caractères peut être symbolisée par un nombre entier, le calcul universel selon les règles de Turing s'applique. On peut alors, étant donnée une chaîne de caractères, définir le programme formel le plus court (en termes algorithmiques du calcul universel de Turing) qui peut compresser une chaîne originelle, ou la restituer une fois donné son état de compression. La valeur de l'information de la chaîne S est définie comme la longueur minimale du programme universel qui peut représenter S sous forme compressée (on utilise, dans ce contexte, le terme de "complexité algorithmique" plutôt que celui d'information).

Vue ainsi, une chaîne S complètement aléatoire ne peut pas être compressée : le programme minimal nécessaire pour compresser S est identique à S (à une constante près). On peut alors définir le caractère aléatoire d'une chaîne par le fait qu'elle n'est pas compressible. Au contraire, une chaîne faite d'éléments répétés (01010101...) peut être condensée sous la forme d'un programme très court : la séquence de l'élément répété (01), et l'instruction "répéter". Ainsi on peut distinguer des séquences de symboles par des propriétés compréhensibles. Cependant, il faut noter que cette définition conduit à un théorème d'existence : toute séquence a une complexité algorithmique, mais on n'a pas de moyen de la connaître. On peut tout au plus savoir, lorsqu'on connaît un moyen de compresser une séquence, que sa complexité algorithmique est au plus de la valeur correspondante.

Au surplus, on se rend vite compte que la longueur de la séquence compressée ne représente pas toute l'information à son sujet. Il conviendrait d'ajouter quelque chose si l'on veut définir l'information de façon plus fine, comme en témoigne l'exemple suivant. Le programme qui définit la suite des décimales de π est fortement compressible, comme l'est le programme qui engendre une séquence répétée dont le motif répété est un peu long. Pourtant, on aimerait pouvoir dire que l'information qu'on apporterait si l'on pouvait d'emblée connaître une décimale donnée de π serait bien plus riche que celle qui se trouve dans la connaissance de la valeur du nième chiffre de la séquence répétée, car elle ne s'obtient pas sans effort...

Représentés sous la forme de chaîne de lettres, les gènes et les chromosomes ont un contenu en information (une complexité) intermédiaire : on trouve des répétitions locales, et, au contraire, des séquences dont l'enchaînement est localement impossible à prédire. Leur complexité est intermédiaire entre celle de l'aléatoire et celle de la répétition. Mais cela n'est certainement pas suffisant. Ces séquences sont porteuses d'une richesse originale, qu'il faut tenter de prendre en compte autrement que par la complexité algorithmique. En particulier il paraît clair qu'une valeur spécifique attachée à une information est son accessibilité réelle. C'est une chose de calculer le contenu en information, c'est une autre chose de l'obtenir effectivement. La complexité algorithmique est une façon de voir synchronique, qui ne se soucie pas de la mise en oeuvre effective de la procédure de compression ou de décompression. Or, cela peut demander du temps, comme nous allons le voir.

Ainsi, non seulement aimerions nous avoir une idée de la complexité de la séquence, mais aussi de l'accessibilité de l'information qu'elle contient. Nous voudrions savoir si elle est utilisable. Si l'on reprend notre exemple et qu'on compare les décimales de π et la séquence 01010101... on remarque aussitôt que, bien que des programmes courts puissent décrire le calcul nécessaire pour engendrer les séquences correspondantes, il y a une différence significative dans leur contenu en information. Car s'il est facile de prédire, à la suite d'un calcul très bref, la valeur de la nième décimale de 01010101... (ou de toute autre séquence répétée plus compliquée), il n'en est pas de même pour π. Dans ce dernier cas, si n est grand il faut un temps très long pour obtenir la valeur exacte de la nième décimale, en mettant en œuvre le programme qui permet le calcul de π (du moins pour l'instant : on a trouvé une solution rapide à cette question, dans le cas où le développement de π est binaire...).

Cette observation est importante pour les séquences engendrées par des programmes récursifs, comme le programme qui décrit la genèse du flocon de Koch. En effet, l'écriture d'un programme peut être brève parce que la procédure qui est réitérée est incluse à l'intérieur du programme, où elle s'appelle elle-même. Lu par une machine de Turing, le programme met un long temps avant de parvenir à l'état où il s'arrête, car il est sans cesse rappelé en arrière. Alors l'information apparente contenue dans la séquence pourrait paraître faible, puisqu'elle est résumée sous la forme d'un programme court. Mais il peut être très laborieux d'obtenir l'information concernant l'un des chiffres de la séquence, qui n'est connue qu'après un temps de calcul très long. Ainsi donner la valeur précise de ce chiffre, correspondrait à une information très riche, si nous possédions un moyen quelconque mais rapide de l'obtenir. Bennett a formalisé cet aspect de l'information, en l'appelant "profondeur logique". La profondeur logique de la séquence S est le temps minimum requis pour engendrer S en utilisant une machine de Turing universelle.

Avec cette introduction du temps nous changeons complètement de paradigme. Ce n'est plus le côté pythagoricien des nombres qui apparaît ici. La profondeur logique se relie au contraire à la distinction aristotélicienne entre potentialité et réalité. Elle donne les raisons qui font qu'on ne devrait jamais parler en termes de potentialité comme on le fait en termes de réalité. Il peut arriver que parler de potentialité n'ait aucun sens, car la réalisation explicite du potentiel est temporellement impossible. Seuls les faits qui sont engendrés mécaniquement, à la manière de l'enchaînement régi par le temps des horloges, pourraient conduire à une assimilation aussi grossière. Cette mécanique-là, typique de l'image du Grand Horloger qui réglait le monde au XVIIIe siècle, est celle qui, longtemps, a fait confondre le déterminé et le prévisible. Elle est encore pensée par certains biologistes lorsqu'ils décrivent les processus moléculaires à l'œuvre dans la cellule, ou même — et c'est plus surprenant — lorsqu'ils prennent en compte les propriétés spécifiques du système nerveux. Mais cela ne peut correspondre à la réalité sous-jacente, infiniment plus riche, et surtout créatrice, comme nous allons le voir.

Plutôt que considérer les organismes vivants en termes de forme extérieure, nous venons de voir qu'il est légitime de rechercher ce qui préside à leur construction et à leur survie, sous la forme d'un programme génétique écrit de manière alphabétique. Cela ne signifie pas pour autant qu'il soit question de réduire la vie à l'étude des nombres entiers. Mais si l'on peut déjà, avec cette image simpliste, dégager des conséquences importantes, a fortiori pourra-t-on penser que les propriétés spécifiques de ces organismes sont plus riches encore.

Rappelons d'abord que les nombres entiers ont des propriétés tout à fait inattendues. Kurt Gödel, en 1931, a démontré qu'il était possible de produire des propositions bien formées (c'est-à-dire qu'on peut considérer comme vraies), concernant les entiers et cependant indécidables à l'intérieur du sens donné à l'axiomatique qui les avait produites. Cela revient à dire qu'il a créé des structures irréductibles à celles qui leur ont donné naissance. Il lui a suffi, pour cela — outre un usage explicite de la finalité, puisqu'il a construit ses exemples en sachant où il voulait en venir — d'établir une règle de codage entre les axiomes et les définitions élémentaires de la théorie et des nombres entiers, puis d'établir une procédure permettant d'engendrer à partir d'un ensemble initial de nouveaux nombres, qu'il a alors traduits à l'envers sous forme de propositions (du type : "Si telles sont les conditions posées au départ, je suis une proposition indécidable"). N'est-il pas possible, en utilisant la métaphore alphabétique du génome, d'imaginer que la séparation entre la mémoire et la fonction, entre le programme et les données, chez les organismes vivants, conduit nécessairement à la genèse de programmes nouveaux dont les propriétés sont irréductibles à celles qui lui ont donné naissance ? Nous verrons plus bas si cela se justifie. Mais si cela est accepté on peut déjà observer que, puisque dans le cas des organismes vivants il faut se passer de finalité tout en conservant une hypothèse de stabilité dans le temps (seules subsistent les espèces suffisamment stables, par définition de leur existence-même), il est nécessaire que les innovations apportées au cours de la genèse contingente des programmes nouveaux, soient suffisamment adaptées à l'environnement, sans cesse changeant et imprévisible, où se trouvent les individus qui les portent. On peut donc considérer que c'est l'échec de la capacité à prévoir qui est le moteur sélectif essentiel qui a conduit aux propriétés essentiellement créatricesde la vie, au travers de la séparation explicite du programme génétique de son environnement cellulaire .

Donner une image de la genèse d'un organisme vivant en termes algorithmiques, tirer les conséquences de cette description en considérant l'imprévisibilité de la genèse de variants à partir d'un programme écrit de façon alphabétique, n'a véritablement de sens que si les présupposés nécessaires à la mise en oeuvre d'une machine de Turing sont effectivement réalisés. Le principal présupposé dont il nous faut donc rendre compte est l'existence d'une séparation physique, réelle, entre la machine d'une part, et les données et le programme, d'autre part. On pourrait craindre, puisque la réalisation concrète des organismes vivants se fait avec de vraies (macro)molécules, que cette séparation ne soit qu'une fiction. Mais il s'agit d'un fait dont beaucoup d'aspects sont déjà bien établis. On peut en effet isoler l'ADN d'un organisme, le placer dans un autre organisme, sans parenté évolutive parfois, et mettre alors en marche un processus de construction où, tout à fait concrètement, le programme (l'ADN), les données (la cellule avec sa membrane et son cytoplasme qui intègrent les paramètres de l'environnement), et la machine (le ribosome et les ARN de transfert, qui décodent le message, mais aussi tout l'appareil permettant la reproduction à l'identique de l'ADN, et son expression spécifique) ont été physiquement séparés. C'est donc rigoureusement vrai si l'on considère des fragments de génomes : c'est par exemple la base de la production de protéines humaines par des colibacilles. Mais c'est vrai aussi de portions génomiques beaucoup plus importantes, et de programmes dont certains aspects sont clairement récursifs : c'est ce que réalisent les virus lorsqu'ils infectent leurs hôtes, s'y reproduisent et s'y multiplient. Mais là encore, ce ne sont que des fragments de génome relativement courts. Pourtant, si l'on considère certains génomes dans leur entier, comme celui du colibacille, nous avons mis en évidence qu'une fraction très importante provient d'échanges entre espèces distinctes.

Ainsi par exemple, dans le cas de cet organisme, un cinquième du génome, au moins, est soumis en permanence à des échanges "horizontaux". Cela se produit à une fréquence assez significative pour que la pression de sélection qui maintient la cohérence de la séquence de l'ADN correspondant soit parfaitement repérable lorsqu'on étudie le génome de l'organisme en question. De même les divers isolats, d'une bactérie du sol, Bacillus cereus, possèdent un génome de longueur très variable (de 2,4 à plus de 6 millions de paires de bases), et il apparaît que ce qui correspond au génome le plus court appartient à toutes les espèces, alors que le reste (qui peut donc être plus long que ce cœur partagé par tous) varie en fonction des biotopes et s'y exprime. Chez le colibacille nous avons montré que cette fraction vagabonde du génome met un jeu un code génétique particulier, tout à fait différent de celui qui optimise l'expression des gènes correspondants en les mettant en conformité avec la répartition des molécules qui servent au décodage (les ARN de transfert) présents dans le cytoplasme du colibacille. Plus encore, on sait détruire le noyau de certaines cellules animales, et par micro-manipulation, injecter le noyau d'une autre cellule (voisine il est vrai) de façon à reconstituer une cellule vivante : c'est le "clonage" qui a fait tant de bruit en 1997. Et en 2007 c’est un chromosome nu qui a été introduit dans une cellule de Mycoplasma genitalium, et qui a remplacé le chromosome original. C'est donc la démonstration de la séparation absolue entre données, machine et programmes, et cela indique que beaucoup de cette séparation est réalisée chez les organismes vivants. Il est donc légitime (i) de considérer que la naissance du vivant coïncide avec la séparation entre données, machine et programmes (ce qui s'est sans doute produit au moment de la genèse de l'ADN, à partir de copies d'ARN ancestraux, et, (ii) d'explorer, sous forme de conjectures, les conséquences formelles de cette séparation. Sous réserve de l'incorporation d'une algorithmique de la genèse des variants (la réplication de l'ADN ne peut être infiniment fidèle), une conséquence essentielle est que d'un programme donné peut naître un nouveau programme, dont les propriétés sont irréductibles à celui qui lui a donné naissance.

Dans ce qui précède nous avons implicitement considéré la cellule, et nous avons vu comment, dans la cellule, l'expression du programme génétique peut produire de l'ontologiquement neuf. Mais on peut étendre cette réflexion aux organismes plus compliqués que sont les plantes ou les animaux : les processus constructifs qui conduisent à la morphogenèse des organismes multicellulaires différenciés sont eux aussi algorithmiques. On sait en effet aujourd'hui que c'est une combinatoire de gènes exprimés de façon séquentielle qui préside à la morphogenèse, et nous avons vu plus haut que cela se reflète dans la structure même du programme génétique, par une différence évidente de complexité algorithmique. La mise en place des formes correspondantes se fait par une suite d'événements qui se déroule à la manière des enchaînements de procédures dans les algorithmes. Dans le cas d'insectes comme la mouche drosophile, par exemple, on a même découvert que les gènes de contrôle de la différenciation cellulaire constituent une sorte de drosophiloculus, orienté sur les chromosomes de la queue vers la tête, la représentation de chaque segment de l'insecte étant formée d'un ensemble génétique situé à la même place relative dans le texte du génome que dans la mouche adulte. C'est l'expression successive de gènes de contrôle, activés un à un qui permet la morphogenèse (en respectant les contraintes de la physique, comme la symétrie globale, par exemple). Et l'expérience montre que l'altération de la succession des gènes de contrôle ainsi identifiés, suffit à altérer le patron morphogénétique : on peut par exemple faire apparaître des antennes à la place des pattes, ou doubler la paire d'aile, faisant ressembler la drosophile à un hyménoptère.

Chez les mammifères la structure segmentée est moins visible que chez les insectes, mais elle existe tout de même au cours de l'embryogenèse (ce sont les somites), et on a découvert récemment avec surprise que des gènes de contrôle homologues de ceux de la drosophile, des homéogènes, existent aussi chez la souris ou chez l'Homme. Dans ce cas, au lieu de former un seul ensemble linéaire correspondant au patron de l'insecte, on trouve quatre ensembles linéaires, ordonnés exactement comme chez la mouche, et correspondant aussi au développement de l'animal de la queue vers la tête. Tout se passe comme si le muriculus (ou l'homunculus) était constitué d'une combinaison ressemblant à ce qu'on peut lire dans la partition musicale d'un quatuor. Cela rend compte de la plus grande complexité des mammifères, comparés aux insectes : l'algorithme de construction provient de la synthèse de quatre procédures homologues mises en œuvre simultanément. Et puisque la cellule est l'atome de vie, ne peut-on rechercher un celluloculus dans l'organisation de certains de ses gènes dans son génome ?

Ainsi, la métaphore alphabétique de l'hérédité, avec sa règle de correspondance entre le texte du génome et son expression, le code génétique, conduit à penser que l'état actuel de chaque organisme vivant est le résultat d'un processus récursif qui, depuis l'origine de la vie, a peu à peu constitué l'information correspondante, en procédant à sa réécriture de génération en génération. De la simultanéité de l'évolution du programme et de la machine qui le met en œuvre provient l'extraction efficace et rapide de l'information, permettant la genèse d'un individu. Comprendre ce que contient le texte du génome ne peut se faire, de façon ultime, qu'en en comprenant l'histoire, qui reflète la profondeur de l'information correspondante. Nous parvenons ici aux limites de la métaphore, puisque ce qu'on sait aujourd'hui des représentations de l'information contenue dans des suites de symboles mène à une réflexion sur la mise en œuvre effective de la machine qui les déchiffre. Il faut insister ici sur le fait que la réflexion sur la profondeur logique de l'information est loin d'épuiser ce que contient le concept (non explicité mais naturel) d'information. En particulier il repose sur l'existence d'une machine parfaite, mais abstraite, la Machine Universelle de Turing. Si la construction de la machine est le résultat de la réalisation d'un programme, il faut alors tenir compte, une fois de plus, du temps, et ne considérer que les algorithmes dont la durée d'exécution n'excède pas la durée de vie de la machine. Ainsi une limite temporelle, définissant les algorithmes qui permettent de construire la machine, doit aussi être prise en considération : elle définit une profondeur critique, qui doit être cruciale dans la genèse des programmes génétiques, et donc des organismes vivants. Pour la profondeur critique il est essentiel de considérer les temps propres des divers processus qui se déroulent simultanément : la conjonction d'événements peut produire une propriété réellement émergente, mesurée par cet espèce de vernier qu'est la mise en relation de deux processus ayant des temps caractéristiques différents (mais, pour qu'il y ait conjonction, commensurables). La formalisation correspondante, qui prendrait en compte l'idée que programmes et machines évoluent de concert, reste à créer. Gageons qu'elle apportera de nouveaux arguments à l'émergence des formes vivantes.

En revenant à l'analyse comparative du texte des génomes on en trouvera un résumé dans le chapitre de la "bible" des spécialistes de E. coli Escherichia coli and Salmonella typhimurium, Cellular and Molecular Biology (ASM Press), paru en 1996 où nous exposons les apports principaux de l'analyse in silico chez cet organisme. Il n'est pas possible ici de faire part de l'étendue inespérée des résultats glanés par l'analyse des génomes complets. On pourra en trouver un résumé dans mon livre La Barque de Delphes, ou ce que révèle le texte des génomes (Odile Jacob, 1998) adapté et mis à jour pour un public anglo-américain, The Delphic Boat.

C. Sélection Naturelle et immortalité

Toute cette réflexion sur l'information conduit à une observation remarquable. D'une part "la création est postérieure au Monde", ou plus exactement elle a cours, de façon permanente, au sein de la Physique, sans demander d'énergie. Cela suppose cependant qu'on accepte d'ajouter aux quatre catégories centrales de la Nature, Matière, Energie, Espace et Temps, une cinquième catégorie, dont on rend compte généralement sous le nom d'Information. Cette création, cependant, ne peut continuer à s'accumuler qu'à la condition de faire de la place, dans l'Espace et dans le Temps (c'est ainsi que s'articule d'abord l'Information avec les quatre catégories classiques). Et ce processus, pour maintenir l'accumulation d'information, doit utiliser de l'énergie afin de ne pas détruire l'information nouvellement créée. Ce processus est celui que nous appelons couramment Sélection Naturelle (voir notre vision scientifique).

Il faut donc, pour comprendre l'articulation de l'information avec les quatre catégories classiques de la Nature, rechercher systématiquement les processus de dégradation qui utilisent de l'énergie au cours de leur action. La Biologie, et plus précisément l'analyse des génomes, permet l'exploration d'une conjecture fascinante : parmi les gènes qui forment le cœur des génomes bactériens, on trouve une série qui codent des fonctions de dégradation des ARN et des protéines, et qui associent à ces fonctions la consommation d'énergie. Mieux, on trouve parmi ces gènes, un ensemble qui gère la synthèse et la dégradation de minéraux, sources ubiquistes d'énergie, les polyphosphates. Il est alors simple d'imaginer — les expériences pour le vérifier sont en cours — que ces systèmes de dégradation utilisant les polyphosphates permettent aux cellules d'accumuler de l'information, sous quelque forme qu'elle puisse se présenter. Une analyse en anglais de cette question est publiée dans la revue Biogerontology, et traduit en français deans le livre Les Mondes Darwiniens, Elle montre brièvement par exemple comment on peut imaginer le cycle de l'immortalisation cancéreuse.

Les analyses génomiques in silico sont complémentaires des analyses in vivo et in vitro, et illustrent une génétique entièrement nouvelle, fascinante, au début du troisième millénaire au moment où les progrès technologiques du séquençage des gènes font exploser la quantité des données à analyser.